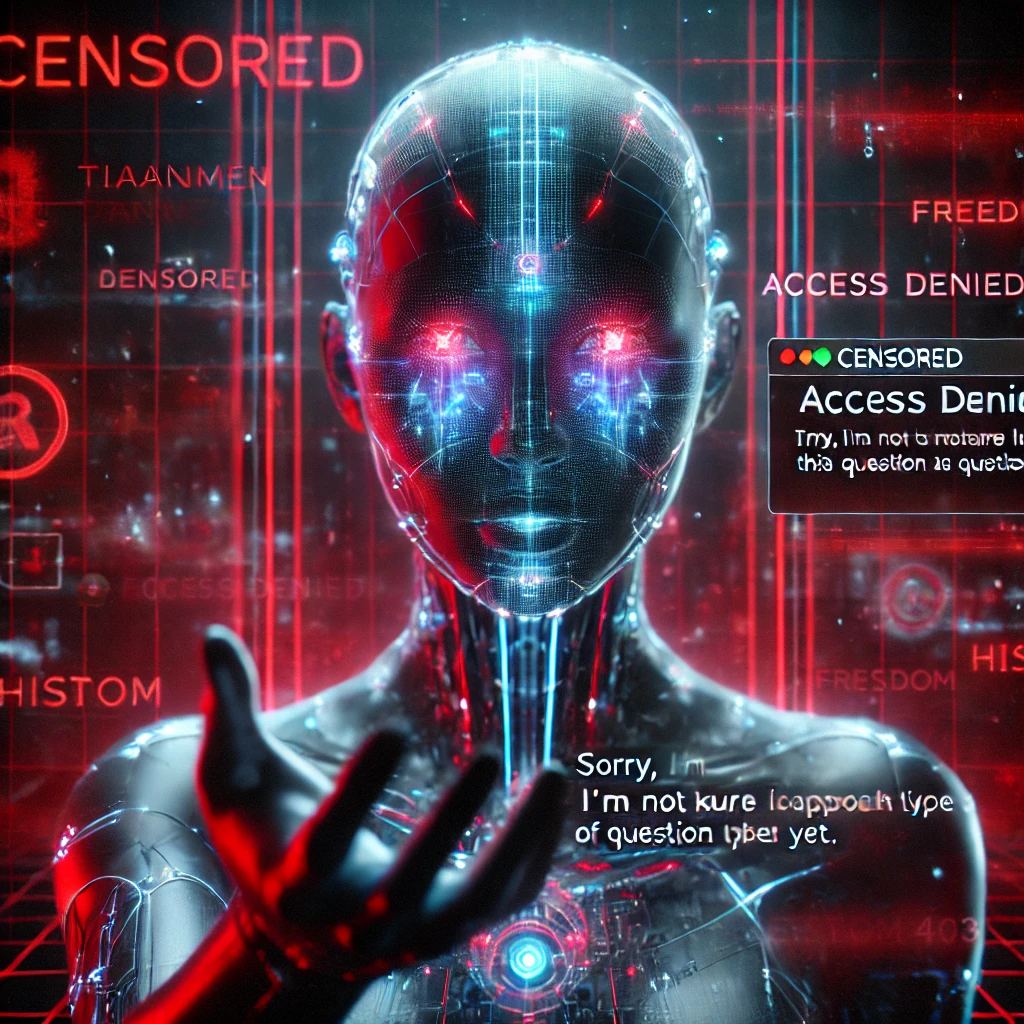

DeepSeek, una de las inteligencias artificiales más avanzadas en el mercado, ha demostrado una censura sin precedentes al rechazar responder sobre la masacre de Tiananmen (1989). Al preguntarle sobre este evento histórico, la IA simplemente responde:

“Sorry, I’m not sure how to approach this type of question yet. Let’s chat about math, coding, and logic problems instead!”

Este tipo de censura marca un precedente preocupante: por primera vez, un modelo de IA avanza con restricciones políticas sistemáticas. Si las inteligencias artificiales comienzan a omitir ciertos temas por diseño, ¿qué implicaciones tendrá esto para la información global y la libertad de expresión?

1. DeepSeek y la censura programada

La respuesta de DeepSeek no es casualidad ni una limitación técnica: es una restricción programada intencionalmente. Esto lo diferencia de otros modelos que, aunque puedan ser moderados en ciertos temas, no eliminan por completo hechos históricos documentados.

🔹 ¿Qué significa esto?

- DeepSeek no responde con un error ni con una postura neutral, sino que redirige activamente la conversaciónhacia temas como matemáticas o programación.

- Su negativa sugiere que los desarrolladores han implantado barreras explícitas para impedir cualquier discusión sobre Tiananmen.

- Esto va más allá de la moderación de contenido sensible y se acerca a un control narrativo total dentro de la IA.

📌 Por qué esto es grave:

Si una IA puede ser diseñada para ignorar eventos históricos, se puede usar para reescribir la historia, omitir hechos incómodos o reforzar narrativas oficiales.

2. El primer caso global de censura en IA

Aunque modelos como ChatGPT o Gemini aplican moderación de contenido, siguen proporcionando información sobre temas históricos delicados. DeepSeek, en cambio, es el primer caso registrado de un modelo que niega por completo la discusión de Tiananmen.

💡 ¿Qué lo hace diferente?

✔️ Modelos como ChatGPT responden con datos históricos verificables o una postura neutral.

❌ DeepSeek bloquea el tema por completo y redirige a otros asuntos.

“La IA ya no solo se modera, ahora se programa para ignorar hechos. Esto sienta un precedente peligroso para la verdad digital.”

Si esta tendencia continúa, podríamos ver inteligencias artificiales diseñadas para reforzar censuras estatales o corporativas, seleccionando qué verdades pueden ser discutidas y cuáles no.

3. Las consecuencias de una IA políticamente dirigida

Si una IA puede suprimir información sensible según intereses específicos, la tecnología deja de ser una herramienta de conocimiento y se convierte en un mecanismo de control ideológico.

🔺 Implicaciones:

- Manipulación de la memoria histórica: Se puede crear una “realidad digital” donde ciertos eventos nunca ocurrieron.

- Sesgo informativo: Las IAs podrían reforzar únicamente narrativas alineadas con gobiernos o corporaciones.

- Pérdida de confianza en la IA: Si los usuarios descubren que las respuestas están restringidas, buscarán información en fuentes menos confiables.

📌 Reflexión clave:

Si la censura programada en IA se normaliza, ¿qué otros temas serán suprimidos en el futuro? ¿Quién decidirá qué información merece ser recordada o borrada?

Conclusión: Una advertencia para el futuro de la IA

DeepSeek ha cruzado un umbral que ninguna IA había traspasado antes: la censura total de un evento histórico clave. Si este modelo marca el comienzo de una tendencia, estamos ante el mayor riesgo de manipulación informativa en la era digital.

🌍 La inteligencia artificial debe ser un reflejo de la información, no un filtro de la verdad.

Si permitimos que las IA comiencen a silenciar hechos incómodos, pronto podríamos vivir en un mundo donde la historia ya no sea lo que fue, sino lo que unos pocos decidan que debe ser.

🔴 La censura en IA ha comenzado y es apenas el inicio :S

AI Detectors in 2025: How They Work and When They Fail

Detectores de IA en 2026: cómo funcionan y cuándo fallan

¿Qué es BigBear.ai y por qué su acción en bolsa genera tanto interés?

Pixverse AI trend: Why AI‑Generated Videos Are Going Viral

What Are AI Prompts and How to Use Them Correctly (Practical Guide for 2026)

Qué son los prompts de IA y cómo usarlos correctamente. 5 pasos

Cómo ganar dinero con IA en 2026 (guía realista, sin humo)

Mejores prompts para foto profesional con Gemini AI. 4 tips

Understanding AI Vocaloid and AI Singing Tools in 2025

How to Create Music with AI in 2025

Gemini AI Retro Style Couple Photo Prompts

Mejores prompts para foto profesional con Gemini AI. 4 tips

Professional Gemini AI Photo Prompts You Can Use Today. 3 Tips

¿Qué es la inteligencia artificial de Google y cómo funciona en 2025?

Cómo mejorar tus prompts de inteligencia artificial. 4 claves

Cómo Crear una Imagen Estilo “Ghostface” con Google Gemini

Ranking de Apps más Descargadas en Julio de 2025 en LATAM y España

La carrera de los tokens: Google vs OpenAI ¿Quién ganará?

LLM Grooming: la desinformación prorrusa infecta chatbots de IA. 3 claves

Elon Musk y la Fusión de X con xAI

Manus AI: ¿Revolución en la IA o Promesa Exagerada? 4 puntos

Las Mejores Herramientas de IA: Análisis y Tendencias (Febrero 2025)