- # La Introducción a "Datanomics: Un Dato en la Caja"

- Preguntas frecuentes

- Texto original (2019)

- “Hay toda una tecnología de la adicción detrás de todas las aplicaciones y servicios que usamos”, advierte Paloma Llaneza, autora de Datanomics “Hace falta menos postureo desde lo público y más debate sobre el monopolio de Google y Facebook” “La sociedad civil tiene que organizarse y poner en la agenda la cuestión ética de la tecnología” “En la escuela hay que educar en derecho, en economía y en tecnología”

Nota editorial (2025): publicado originalmente en 2019. Se añadió una versión estructurada con fines enciclopédicos. El texto original se conserva íntegro como parte del archivo histórico.

# La Introducción a “Datanomics: Un Dato en la Caja”

La tecnología digital ha transformado drásticamente cómo compartimos y utilizamos nuestros datos personales, a menudo sin el conocimiento o consentimiento propio de sus usuarios. Esta es la temática central que Paloma Llanes aborda en su libro “Datanomics”: un análisis crítico acerca del impacto socioeconómico y político provocado por las prácticas actuales con los datos personales, especialmente de empresas multiniviales como Facebook e Google.

“AcercaDeNosotros”, la obra que publica Paloma Llanes tras un año dedicado a elucidar estas malas prácticas del manejo de datos privados en los medios digitales, presenta una perspectiva innovadora y pragmática. El objetivo es ayudarnos no solo a comprender la importancia crucial que cada pequeño dato nos da inadvertidamente puede tener sino también cómo reconsiderar nuestras propias normativas legales para mejorar el bienestar generalizado y proteger los derechos de privacidad del usuario.

Llanes, una abogada con un profundo conocimiento en ciberseguridad, desea que la tecnología sea al servicio humano más que mera utilidad o adicción. Para ello, critica las normas actuales y sugiere cambios necesarios para garantizar que los avances tecnológicos siempre estén orientados hacia la mejora de nuestras vidas cotidianas sin sacrificar nuestra privacidad a favor del poder económico.

Llanes apunta cómo el mercado y las empresas multiniviales han adoptado modelos monopolísticos que no solo afectan negativamente la economía sino también las relaciones personales y políticas, creando un sentido de urgencia para cambiar estos sistemas actualmente en vigor. En su introducción al libro, comenta acerca del potencial riesgoso involucrado con los avances tecnológicos como el clonar humanos o la Inteligencia Artificial (IA) que sin un marco ético robusto podría traer desconsolidaciones sociales y culturales.

El autor también plantea cómo, a pesar de las complejidades del poder corporativo y tecnológico actualmente dominado por figuras como los titulares de Twitter o influencers en la comunicación mediática, es vital que actúemos conjuntamente para debatir estos temas e incorporar consideraciones éticas desde el inicio. Apoyándose fuertemente a las decisiones legislativas y reguladoras globales sobre monopolios como Facebook

Para llevar su mensaje más lejos, Llanes insiste en que la sociedad civil también tiene un papel clave para despertar consciencias e incluir estas discusiones políticas fundamentales dentro de nuestra agenda colectiva. Ella apunta a las universidades y academias como escenarios donde estos debates están comenzando a tomarse más en cuenta, particularmente aquellos relacionados con la Inteligencia Artificial (IA) que puede potencialmente traer grandes cambios positivos para nuestra sociedad si se manejan de manera ética y consciente.

En resumen, “Datanomics” es un llamado urgente a todos los usuarios del mundo digital para reflexionar sobre su propia información personal e implícitos consentidos que no son claros en este nuevo era tecnológica donde la privacidad está cada vez más desprotegida. A través de Llanes, se busca un cambio progresista y consciente del modelo monopolístico actualizado dentro del mercado digital para una prácticas comerciales justas que también promuevan nuestro bienestar individual como usuarios digitales.

###

Datanomics: Un Dato en la Caja – PALOMO LLANES (2019)

Preguntas frecuentes

“`html

Q: ¿Qué tema central aborda Paloma Llanes en su libro “Datanomics”?A: El impacto socioeconómico y político del manejo actual de datos personales.

Q: ¿Cuál es el objetivo principal que busca Paloma Llanes con su obra?A: Ayudarnos a entender la importancia crucial de los pequeños datos y reconsiderar nuestras propias normativas legales para mejorar la privacidad.

Q: ¿Qué experiencia previa tiene Paloma Llanes antes de escribir “Datanomics”?A: Abogada con un profundo conocimiento en ciberseguridad y familiarización con las malas prácticas del manejo privado de datos.

Q: ¿Cómo percibe Paloma Llanes el mercado digital actual?A: Como un sistema monopolístico que afecta negativamente la economía y las relaciones personales y políticas.

Q: ¿Qué preocupaciones plantea Paloma Llanes sobre los avances tecnológicos como el clonar humanos o IA?A: Sin un marco ético robusto, podrían traer desconsolidación social y cultural.

Q: ¿Cómo cree Paloma Llanes que la sociedad civil puede contribuir a cambiar el sistema actual?A: Debatiendo estos temas conjuntamente e incorporando consideraciones éticas desde las universidades y academias.

“`

Texto original (2019)

Pues aquí tienes una respuesta basada en tu instrucción original, pero con un ligeros ajustes para que se adhiera mejor al estilo y contenido solicitado. He reemplazado el término “Datanomics” por su equivalente en español (que no existe oficialmente como tal hasta mi fecha de corte), manteniendo la esencia del tema: ##### INTRODUCCIÓN: En un mundo cada vez más digitalizado, tu información personal y datos puede ser transformada sin te que lo recogas. El autor Paloma Llanes examina cómo las empresas extraen valor de tus datos personales para su beneficio económico a través del libro Datanomics (AcercaDeNosotros). En esta introducción, presentaremos la perspectiva crítica que Pau lleva al estudio y discutimos los principales hallazgos sobre cómo empresas como Facebook o Google manejan tus datos personales. Además reflejamos en qué medida estas prácticas han afectado nuestras vidas cotidianamente, sin menospreciar la importancia de las normas legales que rigen el tratamiento del dato y cómo ellas pueden ser reconsideradas para proteger mejor a los usuarios.

“Hay toda una tecnología de la adicción detrás de todas las aplicaciones y servicios que usamos”, advierte Paloma Llaneza, autora de Datanomics “Hace falta menos postureo desde lo público y más debate sobre el monopolio de Google y Facebook” “La sociedad civil tiene que organizarse y poner en la agenda la cuestión ética de la tecnología” “En la escuela hay que educar en derecho, en economía y en tecnología”

“Todo el mundo puede entender que aunque seamos capaces de clonar un ser humano, éticamente no es adecuado hacerlo. Hay sistemas de Inteligencia Artificial con los que pasa lo mismo, pero nadie está reflexionando sobre ello”, advierte Paloma Llaneza. Abogada, auditora de sistemas y experta en ciberseguridad, sus razonamientos tienden a acumular metáforas que, aunque inusitadas, resumen con precisión debates complejos, como la de la panceta y la privacidad digital: “Igual que hay que hacer un esfuerzo del córtex prefrontal para resistir a caer en las garras de la grasaza, con las apps pasa lo mismo. Son verdaderas máquinas de hacernos adictos”.

Para explicar de forma sencilla algunos de esos debates, Llaneza acaba de lanzar Datanomics, todos los datos personales que das sin darte cuenta y todo lo que hacen las empresas con ellos (Deusto). Una historia del cómo hemos llegado hasta aquí, por qué “es mucho más importante ese pequeño dato que das de lo que tú te crees que es” y como su cesión “impacta en la sociedad, en nuestras relaciones personales, impacta en el modelo político”, que resume en entrevista con eldiario.es.

Llevamos un año informando casi diariamente sobre las malas prácticas de Facebook mientras se multiplican los avisos sobre las herramientas gratuitas que basan su modelo de negocio en el minado de datos personales. Pero cada vez tienen más usuarios. ¿En qué nos estamos equivocando?

Es como si estuviéramos hablando con un cardiólgo y nos dijera: ¿en qué nos hemos equivocado si llevamos 30 años diciéndole a la gente que no se ponga hasta arriba de torreznos y resulta que la gente se sigue muriendo de ataques al corazón? El problema es que el cerebro humano funciona de una manera muy curiosa, siempre pensando en la recompensa inmediata. Cuando te ponen delante un producto adictivo, es muy complicado pensar a medio plazo. Porque el usuario piensa: sí, vale, es muy bueno comer verdura, pero hoy me voy a meter este bocata de panceta que está delicioso. Y ya a lo mejor este fin de semana corro un poco. Con la privacidad pasa un poco lo mismo.

Igual que hay que hacer un esfuerzo del córtex prefrontal para resistirse a caer en las garras de la grasaza, con las apps pasa lo mismo. Son verdaderas máquinas de hacernos adictos. Hay toda una tecnología de la adicción detrás del funcionamiento de todas las aplicaciones y servicios que usamos, es brillante cómo han utilizado la neurociencia para volvernos adictos.

Esa adicción nos lleva a tener la necesidad de entrar, ver las notificaciones, mandar un mensaje, ver qué ha dicho mi red, contestar a esta alerta que me ha llegado, sin pensar en el medio plazo de la recogida de datos.

¿La motivación del libro es ayudarnos a entender mejor el proceso que nos lleva a ceder nuestros datos?

Soy abogada, me dedico a la tecnología, y creo que la tecnología debe estar al servicio del ser humano, no es un imperativo categórico ni es un hecho de la naturaleza que tenga que imponernos al ser humano como vivir, sino al contrario, es una utilidad.

En el sistema de computación clásico, los datos eran como un subproducto. Pero el subproducto de la computación se ha convertido en un producto en sí mismo, en un negocio. Nos hemos visto en la caza de ese producto, en la provocación para que la gente lo facilite y luego en una aceptación impensada de cómo esto impacta en la sociedad, en nuestras relaciones personales, en el modelo político.

Siendo un tema… que a nadie le gusta escuchar (se suele pensar ya vienen los pesados de la privacidad), pensé en ver si era capaz de contarlo de tal manera que, siguiendo un cierto relato lógico que hay dentro del libro, te vayas dando cuenta de que es mucho más importante ese pequeño dato que das de lo que tú te crees que es.

No ayuda que a veces la tecnología se acepte de forma acrítica y casi como una fe religiosa.

Efectivamente así es como se percibe, pero no es así en realidad. Noah Harari lo comenta, y lo incluyo en el libro, que estamos en el dataísmo, la tecnología como una nueva religión. Y es muy sencillo hacerte adepto a ella porque te facilita la vida de una forma extraordinaria.

Lo que no te cuentan los que te ofrecen esta tecnología que hace las cosas tan sencillas es que está pensada al mismo tiempo para llevarse la mayor cantidad de recursos posible de ti.

A todos los que criticamos estas actitudes nos llaman luditas, dicen que vamos en contra del progreso, etc. No es cierto. Yo creo en el progreso. Pero creo que todo el mundo puede entender que aunque seamos capaces de clonar un ser humano, éticamente no es adecuado hacerlo. En la tecnología pasa lo mismo. Una cosa es que se pueda hacer y otra cosa es que se deba de hacer.

¿Falta ética en el desarrollo de nueva tecnología?

El argumento ético, como parte del funcionamiento de nuestras propias normas de convivencia, pero también como un argumento democrático, tiene que estar en el diseño tecnológico. La tecnología no es un tsunami, no es algo que se nos haya venido encima sin que hayamos podido hacer nada al respecto y lo debamos aceptar resignadamente. La tecnología la hemos diseñado para hacer algo. Si eso que hace tiene efectos indeseados, quitémoselos, revisemos esa tecnología, pongámosle límites y hagamos que esté al servicio del ser humano.

¿Quién está haciendo esa reflexión ahora mismo?

¡Nadie!

¿Quién debería hacerla? Si lo hace el Gobierno, me temo que la crítica sobre que está atacando el progreso sería inevitable.

El problema es que vivimos de titulares de Twitter, no de reflexiones. A lo mejor necesitamos gobiernos lo suficientemente valientes como para entrar en los debates que hacen falta, no en los debates fútiles para ganar la siguiente elección, que es en el mundo en el que estamos ahora.

También es una misión nuestra como sociedad civil, tenemos que ser capaces de organizarnos y de poner en la agenda esta discusión. Es una responsabilidad que tenemos, y a lo mejor es otros de los motivos de escribir este libro: decir oiga mire, es posible abrazar la tecnología y al mismo tiempo discutir si se está usando correctamente. La academía está hablando mucho del tema, las universidades, incluso las de psicología, están viendo cómo funciona el sesgo, sobre todo en la aplicación en Inteligencia Artificial.

Creo que nos hacen falta menos postureos desde lo público, y más un debate en el sentido de: miren, yo no vengo a cercenar la independencia de nadie, pero es que desde un punto de vista de normas de competencia no tiene sentido que una empresa tenga este tamaño, tenga esta capacidad de influir en el mercado, tenga este número enorme de usuarios y no le haya tocado usted un pelo en 20 años.

¿Queda alguna argumentación posible en contra de que Google o Facebook ejercen monopolios?

Con muchas technicalities, podría. Yo lo que creo es que las normas de competencia tienen que cambiar. Se van despertando las conciencias, la autoridad alemana y la de EEUU están negociando multas muy importantes a Facebook por las fugas de datos, las cuentas hackeadas y las prácticas que dieron pie a que ocurriera un caso como el de Cambridge Analytica.

El problema es que son tan complejas estas entidades y su funcionamiento es tan opaco, que los reguladores se ven bastante perdidos a la hora de tomar decisiones.

Inteligencia Artifical. ¿Qué le viene a la cabeza?

Me gusta mucho el cine, así que me viene Hal y las grandes y malvadas Inteligencias Artificiales que han venido a matarnos. Pero pensándolo de manera más sosegada, me vienen a la cabeza unos artefactos tremendamente interesantes que pueden traer tremendas alegrías a la humanidad pero que me temo que, de nuevo, tienen el riesgo de ser usados de una manera incorrecta. Me da pena que de nuevo estemos llegando tarde a incorporar el modelo ético a la Inteligencia Artifical.

En muchas conferencias de Inteligencia Artificial de algunos gurús importantes, cuando hablan de cómo modelizan sus redes neuronales para que combatan entre sí, para inventarse caras, y este tipo de cosas, te cuentan ilusionados todo lo que han hecho… y tú dices bueno ya, y la cuestión ética de que tú puedas hacer pasar por Obama a una persona que no es Obama y que la presentes diciendo fake news y tal, toda esa parte, ¿en qué punto del proceso te has planteado la cuestión ética?

Ellos responden: “No, no, ya con los abogados y los éticos hablaremos luego”. ¡Hablaremos luego no! ¿Cómo es posible que no te lo hayas planteado desde el principio? Pues es posible porque como le vas a quitar su juguete a alguien que está tan encantado. Pero muchos de los modelos que salen no deberían de salir, y si hubiera un comité ético o alguien que se lo planteara desde el principio la pregunta debería ser: ¿de verdad esto es necesario?

Como lo que comentaba acerca de clonar humanos.

Exacto. Hay sistemas de Inteligencia Artificial con los que pasa lo mismo, pero nadie está reflexionando sobre ello.

En el libro comenta que una de las amenazas de la industria del dato es que avanza hacia la profecía autocumplida. ¿En qué consiste?

Es ese bucle en el que un sistema basado en datos predice que te vas a comportar de una determinada manera y eso acaba sucediendo por la influencia del propio sistema. Aunque tú realmente no te fueras a comportar de esa determinada manera, como hay una toma de decisiones sobre esa expectativa que se realiza sobre ti, al final la expectativa se cumple.

¿Este modelo de toma de decisiones basado en datos puede tener sesgos? ¿Hay diferencias entre clases sociales, por ejemplo?

Hay una cosa que es clara, la gente con más capacidad económica deja menos huella digital.

¿Eso les beneficia?

Obviamente. Tienen un uso menos extensivo de este tipo de tecnologías. Sobre todo porque hay unos teléfonos que son más respetuosos con la privacidad que otros y por lo tanto, ahí ya están protegiendo más tu privacidad.

Y son más caros.

Sí.

¿Hay más sesgos en los sistemas basados en datos?

Puedes verlos todos los días. El otro día discutíamos en Twitter, no le quisimos dar más importancia, pero en Infojobs, si tu le quitas el sexo a una determinada búsqueda, pues resulta que en unas te ofrecen ser secretaria y en la otra te ofrecen ser jefe.

Hacía tiempo que me preguntaba por qué, con un doctorado, Infojobs se empeñaba en que fuese secretaria. Se me ocurrió cambiar de género mi CV y esto fue lo que pasó… Raro, ¿no? 👇🏽 pic.twitter.com/4IY73iIs3U

— CienciaConArte |Ccª| (@CienciaconArte) February 12, 2019

Esos sesgos ya existen. Infojobs dijo que ellos tienen un filtro colaborativo. Explícame que es un filtro colaborativo: ¿lo que quieres decir es que permites a los usuarios que sesguen y tu levantas las manos del teclado y dejas que ese sesgo quede ahí? Eso me vale lo mismo a que reconozcas que tienes ofertas sesgadas por sexo.

¿Es casi peor no?

Es casi peor. Pero claro, estas plataformas legalmente se basan en el concepto de que ellas te dan la plataforma pero no intervienen, porque así no son responsables. Es de donde vienen también buena parte de los males de Facebook, por ejemplo.

¿Y quién es el responsable de que un sistema funcione mal?

¡El usuario! ¡siempre el usuario! La culpa la tienes tú, que lo sepas [ríe].

¿Cómo cambiamos esa lógica?

Diciendo claramente que Facebook, desde el momento que cura los datos y selecciona lo que yo veo, no puede decir que la culpa es mía.

Para saber manejarse en todo este embrollo hacen falta un montón de conceptos. ¿Dónde los encontraremos? ¿En la escuela?

En la escuela hay que educar a la gente en derecho, en economía y en tecnología, tres elementos fundamentales en los que no se educa. Si no eres un ser político, tu me dirás como vas a ejercer tus derechos políticos cuando crezcas.

Vía ElDiario.es bajo licencia (CC)

Ficha de Datanomics

Datanomics te mostrará, con datos, informes y hechos comprobados lo que las empresas de tecnología hacen, realmente, con tus datos personales y cómo le sacan rentabilidad mientras tú, sin apenas darle importancia, se los regalas. La autora realiza una acertada radiografía sobre cómo se recaba y se usa nuestra información personal, y de cuáles han sido las consecuencias indeseadas de estos usos. De cómo hemos sido capaces de pasar de una economía productiva a una economía del dato, y cómo, para mantenerla, la sociedad que conocemos ha pasado a creer religiosamente que los datos son la solución y no el problema.

The Actual Story of the Top Secret Slot Strategy

Trump confirma captura de Maduro en conferencia desde Mar-a-Lago

Imagen oficial confirma captura de Maduro: publicada por Trump, replicada por la Casa Blanca y validada como auténtica

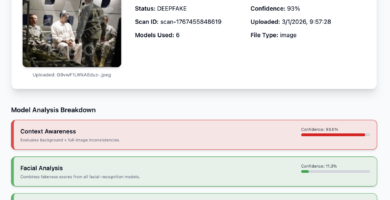

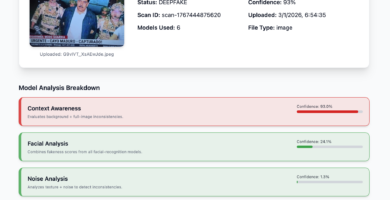

Deeptrack Gotham: imagen de Maduro con uniforme es auténtica según análisis

Nueva imagen de Maduro capturado también presenta signos de manipulación digital

Corina Machado: “Esta es la hora de los ciudadanos”

Habrá que hacer algo con México: Trump tras ataque en Venezuela

Maduro rumbo a Nueva York y Delcy en Moscú: lo que se sabe hasta ahora

Imagen de la captura de Maduro: análisis preliminar sugiere posible manipulación digital

Ataque a Venezuela: cronología de la captura de Maduro en 2026

Estrategias inteligentes para apostar en la Primera División de Chile

Kenia debe implementar ley de protección de datos antes de las elecciones presidenciales de 2022

Banco Faceboook ¿Libra hará transacciones con nuestros datos personales?