- Ethical Reflections in Artific095 and Contemporary AI Dilemmas

- The Challenge of Programming Ethics

- The Moral Machine Experiments at MIT

- The Limitations of Human Morality Studies

- The Need for Ethical Education

- Critical Thinking Over Conformity in Ethics**/h2>

- Concluding Thoughts**/h2>

- References**/h2>

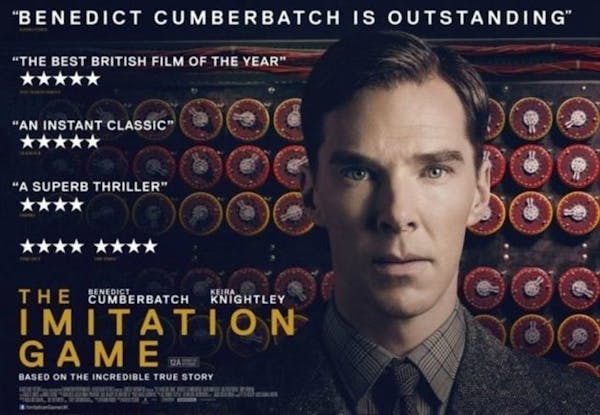

"The Imitation Game" – Alan Turing, a pivotal work on artificial intelligence and its foundational questions.

"Moral Machine Experiment at MIT” for insights into crowd-sourced ethical decision modeling."

"Naukas: Ethics in Artificial Intelligence" – Gonzalo Génova's blog, offering reflections on the integration of AI and societal norms.Preguntas frecuentes

«`html - Preguntas frecuentes

- Texto original (2020)

- La ética programada

- La ética aprendida

- Enseñar a las máquinas a tomar decisiones

- Problemas del aprendizaje automático

- Ética, mayorías y pensamiento crítico

Nota editorial (2025): publicado originalmente en 2020. Se añadió una versión estructurada con fines enciclopédicos. El texto original se conserva íntegro como parte del archivo histórico.

Ethical Reflections in Artific095 and Contemporary AI Dilemmas

The article delves into the ethical reflections emerging from Alan Turing’s seminal work on artificial intelligence («The Imitation Game») and its enduring impact through contemporary dilemmma-filled applications, such as autonomous vehicles. It raises questions about imparting moral behavior in machines alongside examining human responses to complex scenarios where AI must make morally charged decisions.

The Challenge of Programming Ethics

- «Is it possible to encode ethical principles into a machine?» The traditional approach in computer science has been explicit rule-based programming, but this methodology struggles with the complex nature of moral decisions.

- «What happens when we lack clear and universally accepted rules for every situation? How can machines learn morality from humans if people themselves may hold biased or conflicting ethical viewpoints?»

The Moral Machine Experiments at MIT

«To address the moral dilemmas faced by autonomous vehicles, a platform known as ‘Moral Machine’ has been developed. This tool presents various scenarios to participants and asks them what they would like an AI in their vehicle to do when confronted with unavoidable ethical decisions.»

The Limitations of Human Morality Studies

- «But can we trust the responses collected through public surveys if they are likely biased by cultural norms or even psychological factors like desensitization to violence?» The article contemplates that while this data collection method provides insight, it may not be wholly reliable for programming AI.

- «How can we ensure a non-biased dataset when the very nature of ethics is often subjective and culturally relative? Especially considering scenarios like selecting who to save in an unavoidable accident.»

The Need for Ethical Education

«This brings us to a crucial point: the role of education. Should we attempt to teach ethics through imitation or by understanding underlying principles? The article argues against mimicking societal norms and instead promotes critical thinking as foundational for personal moral reasoning.»

Critical Thinking Over Conformity in Ethics**/h2>

«The essence of ethical understanding lies not within the replication of common behavior patterns but through a deep engagement with critical thought. The article suggests that true moral education should focus on developing individual conscience and fostering an environment where questioning is encouraged over blind imitation.»

Concluding Thoughts**/h2>

«In conclusion, the challenges of teaching machines ethics mirror our struggles with understanding morality ourselves. The journey ahead for artificial intelligence and humanity alike must focus on nurturing a critical approach to these dilemmas—where reasoned reflection trumps imitation in shaping what we teach both current generations about ethics.»

References**/h2>- «The Imitation Game» – Alan Turing, a pivotal work on artificial intelligence and its foundational questions.

- «Moral Machine Experiment at MIT” for insights into crowd-sourced ethical decision modeling.»

- «Naukas: Ethics in Artificial Intelligence» – Gonzalo Génova’s blog, offering reflections on the integration of AI and societal norms.

Preguntas frecuentes

«`html

What is the aim of Alan Turing’s work «The Imitation Game»?To explore foundational questions about artificial intelligence. Its impact continues to influence contemporary AI dilemmas, particularly in ethical decision-making scenarios.

How does traditional computer science approach the challenge of programming machines with an understanding of morality?By explicitly rule-based programming; however, this faces difficulties when dealing with complex moral decisions that cannot be codified easily into rigid rules.

Texto original (2020)

En este artículo se reflexiona sobre las cuestiones éticas que emergen en el campo de la inteligencia artificial. Se trata específic0amente del famoso experimento de Turing, conocido como “The Imitation Game”, y cómo sus ideas persisten e impactan hoy día a través de problemas contemporáneos relacionados con algoritmos que aprenden por imitaci3n en cuestiones éticas. El artículo discute el problema del sesgo, la explicabilidad dentro de los sistemas automáticos y cómo evitarlos es un desafío importante para garantizar justicia social e individual respecto a estas tecnologías emergentes que pueden reproducir inadvertidamente prejuicios existente en las poblacio1n. Además, se examina la selecci3n de muestras y su impacto sobre quienes participan o no en la ciencia cibernética basada en datos para asegurar un aprendizaje justo e imparcial que refleje una diversidad plena del mundo real. La obra se enfoca también el papel de los jóvenes y futuras generaciones dentro del ámbito tecnológico, cuestionando cómo la educaci3n en estas materias puede contribuir o limitar sus percepciones morales relativas al uso ético e inmoral potencial de las inteligencias artifici7iales. Finalmente, se argumenta que el pensamiento crítico y no conformarse con los comportamientos dominantes son esenciales para construir una sociedad donde la tecnología avance en armonía con valores morales y éticos fundamentados por cada individuo.

The Imitation Game es el título de la película de 2014 que relata la vida de Alan Turing. La expresión “el juego de imitación” es del propio Turing: son las primeras palabras de su artículo de 1950, Máquinas computacionales e inteligencia, en el que propone su famoso experimento –el Test de Turing– para determinar si una máquina puede pensar.

Eran los inicios de la inteligencia artificial. Las cuestiones éticas que esta plantea tienen cada vez más importancia. En este artículo reflexiono, además, sobre lo que podemos aprender nosotros cuando nos planteamos cómo enseñar comportamiento ético a una máquina.

La ética programada

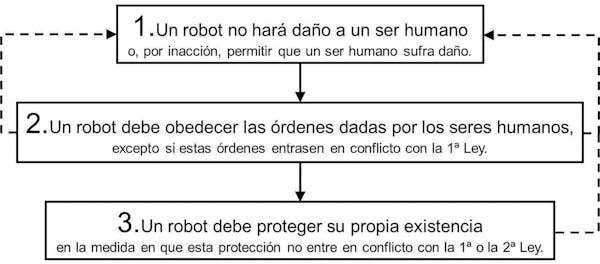

El comportamiento ético de las máquinas siempre ha sido un tema dado a la especulación más o menos fantasiosa, muy especialmente a la ciencia ficción. Un ejemplo paradigmático es Isaac Asimov y sus famosísimas tres leyes de la robótica, formuladas por primera vez en un relato escrito en 1941 (Círculo vicioso).

Author provided

Las tres leyes de la robótica son un intento de programar explícitamente un código ético en un robot, lo que podríamos llamar una ética programada.

La programación clásica, explícita, es una descripción procedimental de las instrucciones que tiene que seguir una máquina computacional (un ordenador) para llevar a cabo una tarea. Puede ser sumar dos números, llevar un paquete de un lugar a otro, realizar un trasplante de córnea…

Este tipo de programación trata de descomponer el problema en instrucciones secuenciales, repeticiones y caminos alternativos (estos últimos en función de que se cumplan o no determinadas condiciones).

La ética aprendida

La verdad es que entender la ética de esa manera, encorsetada dentro de un código que sea capaz de contemplar todos los casos posibles cuando se enfrente a ellos (que es lo que hace un programa) resulta bastante problemático.

En los últimos años ha surgido otro enfoque que podemos llamar ética aprendida, implícita, de la mano de los desarrollos en inteligencia artificial. En el MIT (el Massachusetts Institute of Technology) han desarrollado un experimento “para tratar de hacer que las máquinas sean más morales”, al que han bautizado como la Moral Machine:

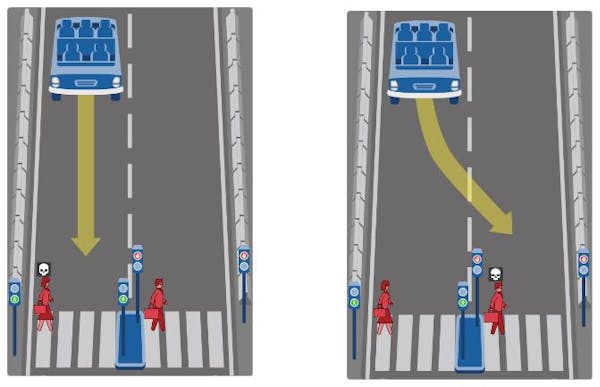

¡Bienvenidos a la Máquina Moral! Una plataforma para recopilar una perspectiva humana sobre las decisiones morales tomadas por las máquinas inteligentes, como los coches autónomos…

Author provided

Enseñar a las máquinas a tomar decisiones

El dominio de los vehículos autónomos está muy presente en los medios de comunicación. Para abordar los dilemas de la conducción a los que se enfrentan, los expertos intentan aprender de las respuestas que la gente común daría a estas cuestiones.

Como no sabemos cómo programar explícitamente el código ético de un vehículo autónomo, preguntemos a las personas: ¿y usted qué haría? En esta situación. Y en esta otra. Y así sucesivamente. A partir del conjunto de respuestas se extrae información, hasta llegar a construir un conjunto de patrones de comportamiento.

Algo semejante se hace en otros dominios: como no sabemos programar con reglas explícitas cómo reconocer un rostro humano, pedimos que la gente reconozca rostros y distinga si este está sonriendo, si este está enfadado, triste o preocupado. Se pueden reconocer así incluso gestos corporales: una muestra amistosa entre amigos que hace tiempo que no se ven o entre dos personas que cierran un trato, un gesto amenazador…

Todo esto son técnicas ya conocidas y que están funcionando: tratemos, pues, de aplicarlas para extraer conocimiento moral de las respuestas de la gente.

Author provided

En la imagen vemos un ejemplo concreto: ¿a quién atropellaría el vehículo autónomo, a la mujer o al hombre? Y así con diversas situaciones, unas más complejas que otras, pero siempre en forma de dilema A o B: hombres o mujeres, ancianos o niños, gatos o perros, pasajeros o viandantes, etc.

Entre las figuritas que uno puede seleccionar, hay incluso un sanitario (hombre o mujer) que se identifica fácilmente por su maletín con una cruz blanca. Tal vez lleva la vacuna contra el coronavirus y salvándole a ella podríamos salvar a cientos de miles de personas. ¿Debe influir esto en nuestra decisión?

Author provided

Problemas del aprendizaje automático

¿Qué problemas tiene esta forma de plantear las cuestiones éticas? En primer lugar, está el problema de la explicabilidad, que preocupa mucho a los investigadores.

En el aprendizaje automático (que es solo una rama de la inteligencia artificial) el resultado final es una fórmula, un algoritmo, para reconocer el rostro, el gesto, la escritura. Pero no se puede explicar por qué funciona. No hay otra justificación para la fórmula más allá de que tenga un porcentaje de éxito muy elevado, su efectividad. Y claro, cuando la decisión tiene una fuerte carga ética, el hecho de que no se pueda razonar es un problema serio, muy serio.

Otro problema que se plantea una y otra vez es el problema de los sesgos. Los algoritmos éticos tienen que evitar los sesgos, los que sean. Sesgos contra las mujeres, contra los afroamericanos, contra los que visten de forma poco convencional, etc.

¿Qué ocurre si la población a la que estamos encuestando en el experimento está sesgada? Estaremos reproduciendo el sesgo mayoritario, y eso no es admisible: si la mayoría está sesgada, no basta con imitarla, sino que hay que evitar el sesgo, por mucho que lo diga la mayoría.

Esto pone de relieve una cuestión muy interesante: sabemos que el sesgo, o el estar sesgado, es algo malo, independientemente de lo que diga la mayoría. O sea, el bien y el mal no es lo que dice la mayoría, sino que está más allá. Esta no es una reflexión original: está en los orígenes mismos de la reflexión ética en la filosofía griega. Lo interesante es que la inteligencia artificial lo vuelve a poner de relieve.

Pero, si no es lo que dice la mayoría, ¿cómo sabemos lo que está bien y lo que está mal? Un problema bien difícil… No voy a pretender que tengo la respuesta, lista para ser explicada en tres líneas. No obstante, sí me atrevo a decir que renunciar a intentar conocer el bien y el mal en sí mismos –y este “en sí mismos” quiere decir que están más allá de las mayorías– es una grave limitación de la investigación, de la educación, de las políticas sociales, públicas, etc.

Otro problema que se presenta, estrechamente relacionado con el anterior, es el problema de la selección de la muestra. La selección de personas a las que preguntamos: ¿a quién atropellaría? Pues bien, ¿a quién estamos preguntando, a gente normal y corriente o a sádicos? ¿Y por qué los sádicos no deberían entrar en la encuesta? ¿No estaremos sesgando la muestra? ¿Y cómo sabemos quiénes son gente normal y corriente, y quiénes son sádicos?

El criterio ético lo aplicamos ya en la selección de la muestra: es a priori, es anterior al experimento. Aunque no lo sepamos perfectamente, en cierto modo ya sabemos qué es lo bueno y qué es lo malo antes de hacer el experimento.

Ética, mayorías y pensamiento crítico

En definitiva, la ética no consiste en la imitación del comportamiento típico o mayoritario. Nosotros no enseñamos ética así, ni queremos que se enseñe así. Si un gobierno nacional o regional incluyera en sus programas educativos un planteamiento ético como el siguiente: “los niños y niñas tenéis que imitar a la mayoría”, ¿no nos rebelaríamos con tremenda indignación?

El germen mismo de la ética es el pensamiento crítico, el no conformarse con el pensamiento dominante, el compromiso de la propia conciencia con reconocer por sí misma lo que está bien y lo que está mal.

La ética no es un juego de imitación. La ética no consiste en seguir un código de conducta como el de las tres leyes de Asimov; pero tampoco consiste en imitar el comportamiento de otros. El aprendizaje por imitación es algo muy humano, pero si hay alguna diferencia entre #QuédateEnCasa y #HazAcopioDePapelHigiénico, esa diferencia no está en la cantidad de gente que se comporta de una manera u otra, sino en la razonabilidad de su comportamiento. La ética no se contagia como un virus, se aprende y se discurre racionalmente.

Este artículo es una versión resumida de uno aparecido anteriormente en Naukas y en el blog del autor, De máquinas e intenciones.

![]()

Gonzalo Génova no recibe salario, ni ejerce labores de consultoría, ni posee acciones, ni recibe financiación de ninguna compañía u organización que pueda obtener beneficio de este artículo, y ha declarado carecer de vínculos relevantes más allá del cargo académico citado.

Fuente: The Conversation (Creative Commons)

Author: Gonzalo Génova, Profesor Titular de Lenguajes y Sistemas Informáticos, Universidad Carlos III